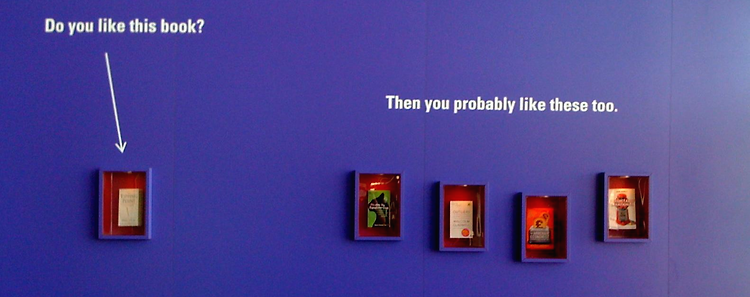

추천시스템 서론 기술통계의 방법론(인기도, 평균 등)을 사용하면 쉽게 일반적인 추천을 만들어 낼 수 있지만, 개인화가 없다면 추천법이 효과적이지 않을 수 밖에 없다. 첫번째 개인화의 방법으로 약한 개인화의 방법인 인구통계적인 방법론을 이야기 할것이다. 인구통계 인기도는 개개인의 선호도가 전혀 반영되어 있지 않은 정보이다. 예를 들어 빌보드에 인기있는 음악들은 젊은 사람들의 선호도로 가득 차 있을 수 밖에 없다. 따라서 그 차트에는 내가 원하는 음악이 없을 수도 있다. 조금의 개인화를 반영하기 위해서는, 전체를 여러 집단(cohort)으로 나누어 볼 수 있을 것이다. 나이 성별 인종/민족성 사회경제적 상태 지역 위의 정보 외에도 인구통계적인 방법은 아니지만, 쉽게 예상 가능한 범주 내에 있는 집단을 만들 ..